2026/02/09

AI

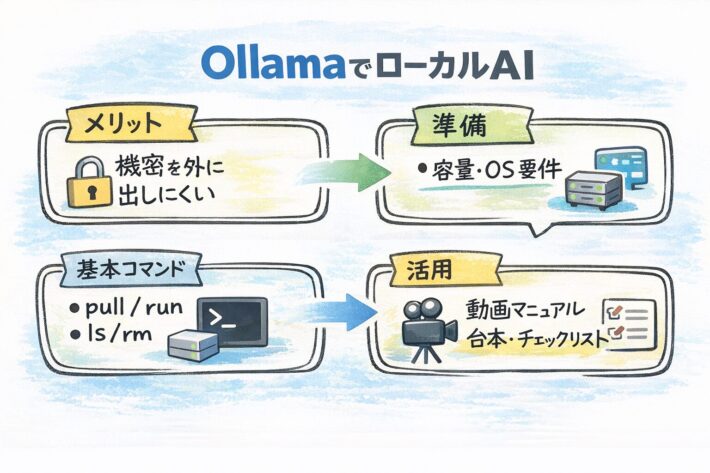

Ollama入門|ローカルAIを5分で試す

「クラウドAIは便利だけど、機密データを入れにくい」「オフライン環境でもAIを動かしたい」──そんなときに役立つのが、ローカルで大規模言語モデル(LLM)を動かせるOllamaです。macOS/Windows/Linuxに対応し、CLIやAPIで気軽に試せます。この記事では、導入から動作確認、仕事に活かすコツ(動画マニュアル作成にも直結)までを、つまずきやすいポイント込みでまとめます。

目次

1. OllamaでローカルAIを試すメリット

ローカルAIが向くケース

- 社内ルール上、外部クラウドに文章を送れない(個人情報・顧客情報・機密情報)

- ネットワーク制限がある現場(工場・倉庫・閉域網)

- 検証を高速に回したい(プロンプト改善、RAG前提の試験など)

- 社内向け動画マニュアルの台本・要約・Q&Aを「外に出さずに」作りたい

クラウドAIとローカルAIのざっくり比較

| 観点 | クラウドAI | ローカルAI(Ollama) |

|---|---|---|

| 情報管理 | 外部送信が前提。ポリシー/設定で対策 | 端末内で完結しやすい(モデルDLは必要) |

| コスト | 従量課金/サブスクが中心 | 基本は端末リソース(電気代・PC性能) |

| 性能 | 最新・大型モデルで強い | 端末性能に依存(小型モデルが現実的) |

| 運用 | 管理はラクだが規約・監査が必要 | 端末/社内配布・更新・容量管理が必要 |

まず覚える結論

- 最初は「インストール → 1モデル実行 → 使い道を1つ決める」が最短です。

- OllamaはローカルでAPI(

http://localhost:11434)を提供するので、後からツール連携もしやすいです。

2. 事前準備:必要スペックと容量の考え方

OS要件(公式)

- Windows:Windows 10 以降(公式にはWindows 10 22H2以降が要件として案内)

- macOS:macOS 14 Sonoma以降(Apple MシリーズはCPU/GPU、x86はCPU中心)

- Linux:ワンコマンド導入が可能。GPU利用はCUDA/ROCmなどドライバ側も整える

※ダウンロードページの要件も必ず確認してください(Windows 10 or later / macOS 14 Sonoma or later など)。

容量の落とし穴(ここで詰まりがち)

- Ollama本体は数GBでも、モデルは「数GB〜数十GB」になりやすいです。

- モデルをいくつも試すとすぐにディスクが埋まります。最初は1〜2モデルだけでOK。

- Windows/macOSともに、モデル保存場所を変更できます(Windowsは環境変数

OLLAMA_MODELSで変更可能)。

失敗しないモデル選び(最初の1本)

- まずは公式クイックスタートで案内される「gemma3」から始めると迷いにくいです。

- 日本語中心なら「日本語が得意な小型モデル」を試し、回答品質よりも“動いた”を優先してください。

3. Ollamaのインストール手順(Windows/macOS/Linux)

Windows:GUIインストーラが最短

- 公式のダウンロードページからWindows版インストーラを入手

- インストール後、Ollamaはバックグラウンドで動作し、

cmd/PowerShellでollamaコマンドが使えます - 動作確認:

ollama -v(バージョンが出ればOK)

補足:インストール先を変えたい場合、インストーラにフラグを付けられます(例:OllamaSetup.exe /DIR="d:\some\location")。モデル保存先は環境変数OLLAMA_MODELSで変更できます。

macOS:dmgをApplicationsへ

- 公式のダウンロードページからmacOS版(dmg)を入手

Applicationsへドラッグ&ドロップ- 初回起動時にCLI(

ollama)がPATHに無い場合、/usr/local/binへリンク作成の許可が求められることがあります - 動作確認:

ollama -v

Linux:ワンコマンドが最短

インストール:

curl -fsSL https://ollama.com/install.sh | sh

起動:

ollama serve

動作確認:

ollama -v

Linuxでは常駐運用(systemdサービス化)が推奨されています。GPUを使う場合はCUDA/ROCmのドライバ導入も検討してください。

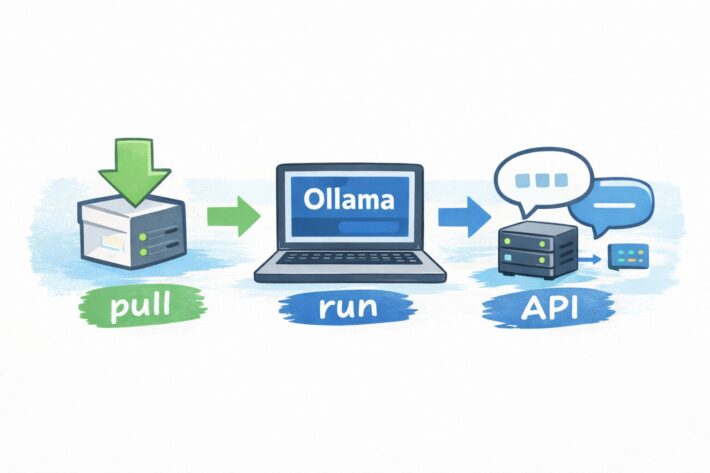

4. まずは動かす:基本コマンドとAPI(ここまでで“試せた”状態)

ステップ1:モデルを実行(最短ルート)

ターミナルで以下を実行します。

ollama run gemma3

初回はモデルのダウンロードが走ります。完了後、対話モードになります。

ステップ2:覚えるべき基本コマンド

- モデル取得:

ollama pull gemma3 - モデル一覧:

ollama ls - 起動中モデル一覧:

ollama ps - 停止:

ollama stop gemma3 - 削除:

ollama rm gemma3

ステップ3:APIで叩く(ツール連携の入口)

OllamaはローカルでAPIを公開します。まずはチャットAPIの例(streamなし)を試します。

curl http://localhost:11434/api/chat -d '{"model":"gemma3","messages":[{"role":"user","content":"こんにちは。要点を3つでまとめて"}],"stream":false}'

ステップ4:自分用に“口調”や“役割”を固定(Modelfile)

毎回同じ指示を書くのが面倒なら、Modelfileで「あなたは〇〇の担当者」などの前提を焼き込めます。

- 例:ベースモデルを指定し、システム指示を設定

FROM gemma3

SYSTEM """あなたは業務マニュアル編集者です。結論→手順→注意点の順で短く書きます。"""

作成コマンド:

ollama create -f Modelfile

つまずき対策:よくある症状と切り分け

- 遅い:モデルが大きすぎる可能性。まず小さめモデルにする/他アプリを閉じる/GPU設定とドライバを確認

- ディスクが足りない:不要モデルを

ollama rmで削除、保存先を別ドライブへ(WindowsはOLLAMA_MODELS) - APIに繋がらない:Ollamaが起動しているか確認(Windows/macOSは常駐、Linuxは

ollama serve) - 文字化けっぽい表示:Windowsでは古いフォントで進捗表示が「□」になることがあるため、ターミナルのフォント設定を変更

5. 仕事に使う:動画マニュアル×ローカルAIの実践アイデア

ローカルAIが動画マニュアル作成に効く理由

- 現場の手順書・ヒヤリハット・教育資料など、外部に出したくない文書を扱いがち

- 台本化・要約・チェックリスト化など、LLMが得意な「文章変換」を大量に回す

- 社内ポリシーに合わせて、出力の型(テンプレ)を固定しやすい(Modelfile運用)

すぐ使えるプロンプト例(台本・チェック・Q&A)

1)手順書→動画台本(ナレーション)

あなたは動画マニュアルの台本作家です。以下の手順書を、(1)冒頭の注意 (2)手順を番号付き (3)よくある失敗と対策 (4)締め の構成で、1分版の台本にしてください。専門用語は言い換え、数字は口頭で読みやすく。

2)作業の品質を上げるチェックリスト化

以下の作業手順から、現場で使うチェックリストを作成。チェック項目は10〜15個、重要度(高/中/低)も付ける。最後に「NG例」を3つ。

3)教育用の理解度テスト(クイズ)

新人向けに四択クイズを5問作って。正解と解説も。ミスしやすい点を中心に。

運用のコツ:社内で事故らないためのルール

- 入力禁止データ(個人情報・顧客情報・機密)を明文化し、例を添える

- 生成物はそのまま使わずレビュー(誤り・古い手順・安全上の不備が混ざりうる)

- モデルとプロンプトは版管理(いつの出力か追えるように)

- 「誰が」「何を」「どこまで」使ってよいかを、短い動画マニュアルにして周知すると浸透しやすい

関連記事

まとめ

Ollamaなら、ローカル環境でLLMを動かし、CLIとAPIで手軽に検証できます。まずはインストール後に「ollama run gemma3」で動作確認し、モデル管理(pull/ls/rm)とAPI(localhost:11434)を押さえるのが最短ルート。機密を扱う動画マニュアルの台本化・チェックリスト化にも相性が良いので、用途を1つ決めて運用ルールとセットで定着させましょう。

Posts by Topic

- 3T'sの特徴(9)

- AI(35)

- DX(35)

- LMS(3)

- セキュリティ(8)

- ビジネス(20)

- ビジネススキル(24)

- ヘルプ(1)

- マニュアル作成の基礎(17)

- メディア掲載(1)

- リスキリング(7)

- 事務に役立つツール(12)

- 動画マニュアル(124)

- 動画撮影(8)

- 動画編集(15)

- 動画編集アプリ(7)

- 外国人労働者(3)

- 導入事例(3)

- 技術継承(9)

- 新人教育(23)

- 未分類(3)

- 用語辞典(20)

- 社内教育(24)

おすすめ記事

- サイクルタイム・タクトタイム・リードタイムの違いは?製造現場の基本と短縮手順をやさしく解説|計測・ボトルネック特定・改善例まで

- 【2025年保存版】Microsoft Officeで簡単マニュアル作成術!EXCEL・PowerPoint・Word活用法

- AI翻訳×動画マニュアルでインバウンド対策を強化!3T’sが提供する最新ソリューションの魅力

- マニュアル作成は誰がするべきか?役割分担の最適解

- Z世代の心をつかむ!動画を活用した新人教育の最新手法

新着記事